-

Файл robots.txt и карта сайта sitemap.xml

4Декабря

Сегодня я расскажу о таких вещах как файл robots.txt и sitemap.xml. Зачем они нужны и почему так необходимы для каждого сайта или блога.

Начну с файла robots.txt – это файл ограничения доступа поисковых роботов к определённым папкам или файлам на вашем сайте, блоге.

Поместить его нужно в корне своего сайта/блога. Так как у меня сайт самописный, то готового решения нет! Сейчас я вам расскажу, как можно создать файл robots.txt. Но прежде, зачем он всё-таки нужен? Как только поисковик посещает ваш сайт, он первым делом ищет этот файл, т.к. именно там указано, что можно индексировать на сайте, а что нет! Ещё он указывает на наличие sitemap.xml – карты сайта, о ней написано ниже. На любом сайте существует множество папок, каталогов, файлов которые индексировать не нужно поисковым «ботам» по различным причинам, да и просто, чтобы поисковик не тратил на них время, а индексировал только нужную, полезную информацию! Советую уделить файлу robots.txt особое внимание!Как создать файл robots.txt?

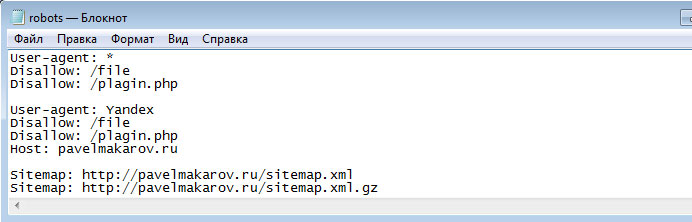

Легко! Откройте блокнот, сохраните как robots.txt, пропишите примерно следущее:

Теперь разберём, что здесь написано:

User-agent: * – все поисковые машины.

Disallow: /file – запрет индексировать все файлы и папки в каталоге file.

Disallow: /plagin.php – запрет индексирования файла plagin.php

Ниже написано всё тоже самое уже конкретно для робота Яндекса. Также указаны пути на файлы карты сайта. По такому же принципу вы теперь можете создать свой файл robots.txt, ну а теперь перейдём к карте сайта!Карта сайта sitemap.xml, что такое sitemap?

Sitemap.xml – это карта вашего сайта. Это единый документ в формате .xml, в котором находятся абсолютно все ссылки на страницы вашего сайта.

Зачем нужен sitemap.xml?

Карта сайта необходима для поисковых машин, чтобы они быстрее и качественнее сканировали ваш сайт. Чтобы не пропустили какую-нибудь важную страничку и проиндексировали её обязательно! Если сейчас на вашем сайте ещё нет статей, то нет смысла отправлять файл sitemap.xml, но когда у вас на сайте или блоге появится контент…, обязательно отправьте «карту сайта» поисковикам и делайте это регулярно! Я стараюсь делать это раз в неделю, по мере написания новых статей. На сайтах поисковиков yandex.ru и google.ru вы можете отправить файл sitemap.xml в разделах «инструменты для web-мастеров».Как создать файл sitemap.xml?

Легко! Лично я пользуюсь on-line сервисом: .На этом всё. С уважением, Павел Макаров.

P.S. Буду рад комментариям к этому посту.

-

Комментарии

9

Вы можете авторизироваться!

-

06 Января 2014 16:02

06 Января 2014 16:02Владимир

ОтветитьПривет! Как к специалисту вопрос имею, надеюсь знаешь что случилось. У меня на вордпресс два сайта, в одном всё в порядке, и роботс и сайтмэп существуют и работают, а сгенерированы плагином всё в одном, SEO OL in ONE, кажется. Ещё один делать начал, а там не получается ничего, как понять? Почему? Наборы плагинов одинаковые... Где искать ошибку? Чего я упустил?

-

30 Января 2014 23:47

30 Января 2014 23:47Nick

ОтветитьПолезно спасибо! А я создаю robots.txt автоматически через сервис и не замарачиваюсь :-) www.hotorg.ru/webmaster/tools/robots-txt-builder/index.php

-

23 Февраля 2014 14:39

23 Февраля 2014 14:39artem

Ответитьскажите обрабатываю ситимап на генераторе мне пишет Сайт не удалось обработать Причина: с главной страницы сайта идет редирект на внешний ресурс HTTP/1.1 302 Moved Temporarily Location: http://zarabotay-tyta.blogspot.ru/ Content-Type: text/html; charset=UTF-8 Date: Sun, 23 Feb 2014 10:26:04 GMT Expires: Sun, 23 Feb 2014 10:26:04 GMT Cache-Control: private, max-age=0 X-Content-Type-Options: nosniff X-Frame-Options: SAMEORIGIN X-XSS-Protection: 1; mode=block Server: GSE Alternate-Protocol: 80:quic Transfer-Encoding: chunked

-

31 Марта 2014 03:44

31 Марта 2014 03:44МихаилUA

ОтветитьДоброе время суток Павел ! Прочитал Вашу статью. Решил воспользоваться on-line сервисом: сайт мэп генератор. Сайт не удалось обработать Причина: неподдерживаемая CMS сайта.

-

24 Мая 2014 15:28

24 Мая 2014 15:28Ольга

ОтветитьПодскажите, пожалуйста, у меня в Инструментах для вебмастеров Google написано: «Файл Sitemap является страницей HTML», что делать? Что это значит?

-

29 Июня 2014 14:26

29 Июня 2014 14:26Павел Макаров

ОтветитьОльга, всё правильно, карта сайта может являться страницей HTML. Обычно такую страницу вебмастер делает самостоятельно. Например на моём сайте карта сайта в формате HTML: http://pavelmakarov.ru/karta-saita.php

-

-

10 Июня 2016 18:13

10 Июня 2016 18:13Tamara

ОтветитьДобрый день! У меня нет файла Robots.txt. Я обязательно должна его создать? Код вы привели. Я должна его поместить в Robots.txt. Если нет файла значит рубрики закрыты от индексации? Я новичок. Не знаю с чего начать. Помогите.

-

05 Июля 2016 20:54

05 Июля 2016 20:54Павел Макаров

ОтветитьTamara, наличие файла robots.txt не обязательно, но желательно на Вашем сайте. Он как правило нужен чтобы закрыть от индексации различные системные (служебные) файлы Вашего сайта, которые могут засорять поисковую выдачу и понижать релевантность других важных страниц Вашего сайта. Приведённый мною код файла robots.txt - это пример, в Вашем случае код будет другим.

-

-

Павел Макаров

Владимир, может быть проблема в более новой версии движка WordPress? Несовместимости плагинов? К сожалению не могу конкретнее ответить. Нужно смотреть сайт.